勾引 小红书为何让歪果仁上面?推选算法超牛,2篇中枢论文揭秘

【新智元导读】如今越来越多的歪果一又友入驻小红书勾引,而这泼天流量也带来了「欲戴金冠,必承其重」的局面。而让环球纷繁赞叹的小红书内容推选算法例是它大概接的下来这波流量的中枢原因之一。本文通过对两篇小红书官方团队发布的推选算法论文解读,带你揭开小红书内容推选机制的奥密面纱。

最近番邦一又友荒诞涌入「Xiaohongshu」,网友直呼,通宵之间与海外接轨。

这场史称「好意思洲大迁移」的互联网奇象,也离不开小红册自身过硬的内容推选算法工夫。而歪果网友也绝不惜啬对于「Xiaohongshu」推选算法的传诵。

01 小红书怎样「投你所好」

接下来让咱们望望,小红书的推选算法是奈何不停地见效「投你所好」。

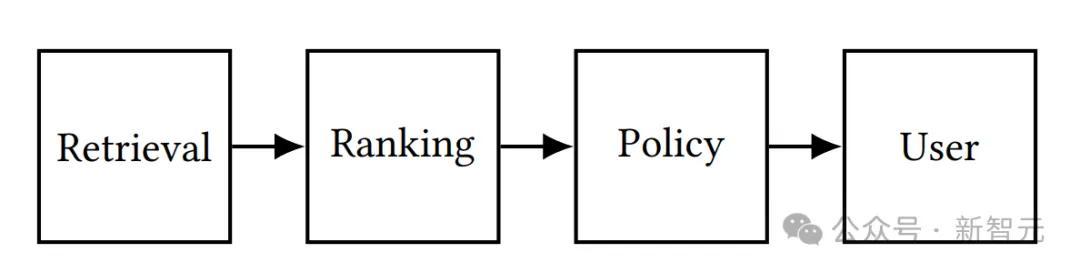

一般来讲,为了构建出用户所可爱的推选内容列表,经典的推选系统组成为:

从内容数据库中检索候选内容

通过排序模块忖度每个事件的质地,即预计特定内容将为用户提供的遵循进度

高质地内容将被发送至战术模块进行进一步筛选和再行排序,以构建最终的推选列表

推选系统的典型结构

现在大概检索到的小红书官方发表的推选算法磋商的工夫论文共有两篇,接下来就让咱们一齐揭开小红书内容推选机制的「奥密面纱」。

02 发现你的有趣有趣:NoteLLM

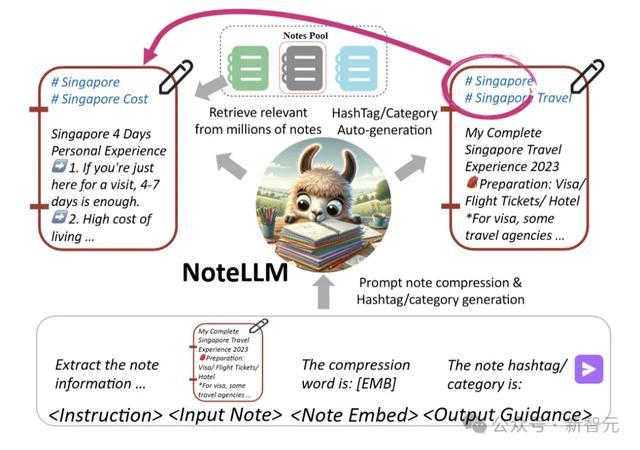

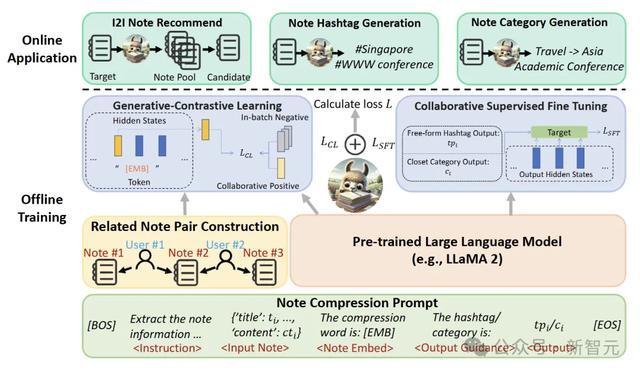

推选契合用户有趣有趣的条记是一项瑕疵任务。NoteLLM是一种用于惩办内容到内容(I2I)条记推选问题的编削和谐框架,旨在为用户提供更精确的条记推选处事。

磋商者在小红书开展了为期一周的在线I2I推选实验。

与先前使用SentenceBERT的表率比较,NoteLLM的点击率提高了16.20%,调回性能的增强使批驳数增多1.10%,平均每周发布者数目增多0.41%。

这些收尾袒露,将LLM用于I2I条记推选任务能显耀提高推选性能和用户体验。同期,新条记一天内批驳数显耀增多3.58%,标明LLM的泛化才略对冷启下条记有积极作用。

现在,NoteLLM已部署在小红书的I2I条记推选任务中。

具体来说,通过「条记压缩辅导词」将条记浓缩成荒谬的单一token,再借助对比学习表率,进一步学习潜在磋商条记的镶嵌关系。同期,NoteLLM还能对条记进行回顾,通过指示调优自动生成标签或类别。

经无数践诺场景考证,NoteLLM在小红书推选系统里效率显耀。

论文王人集:https://arxiv.org/pdf/2403.01744

基于BERT模子的在线I2I条记推选表率存在局限性,它们仅把标签/类别行为条记内容的夙昔部分,未深挖其潜在价值。标签/类别蕴含着条记的中枢重点,对判断条记间内容磋商性至关穷苦。

生成标签/类别与生成条记镶嵌具有雷同性,二者都能将条记瑕疵信息凝练为有限内容。学习生成标签/类别,有助于提高镶嵌质地。

NoteLLM框架由三个瑕疵部分组成:条记压缩辅导构建、生成对比学习(GCL)和吞并监督微调(CSFT)。

磋商者禁受和谐的条记压缩辅导,旨在将条记内容压缩成一个荒谬的单一token,来助力I2I推选和生成任务。

利用这个压缩后的荒谬token,通过生成对比学习(GCL)挖掘其中的吞并常识。之后,借助吞并监督微调(CSFT),诳骗这些常识生成标签和类别。

构建条记压缩辅导

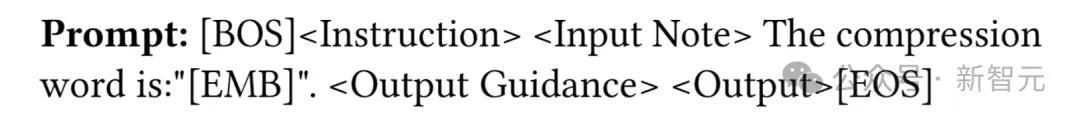

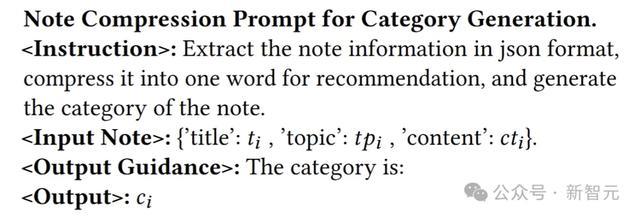

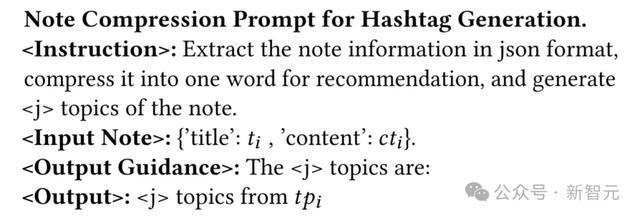

磋商者用以下辅导模板,终明晰对条记的通用压缩以及标签和类别的生成:

在这个模板里,[BOS]、[EMB] 和 [EOS] 是荒谬的 token 。而(指示)、(输入条记)、(输出教悔)和(输出收尾)是占位符,后续会被具体内容替换。

类别生成的具体内容界说如下:

标签生成的模板如下:

完成辅导构建后,对其进行标志化处理并输入LLM,LLM会将吞并信号与瑕疵语义信息提真金不怕火到压缩词中,依据条记中枢想想生成标签或类别。

生成对比学习(GCL)

磋商者冷漠生成式对比学习(GCL),目的是增强LLM拿获更强吞并信号的才略。GCL不同于从特定谜底或奖励模子中学习,它禁受对比学习,从举座视角考量条记之间关系的考究进度。

为了将吞并信号融入LLM,禁受基于用户行径的共现机制来构建磋商条记对。这一机制基于这么的假定:若两篇条记常被用户一齐阅读,那么它们很可能存在关联。

在构建磋商条记对之后,考试NoteLLM基于文本语义和吞并信号判断条记的磋商性。

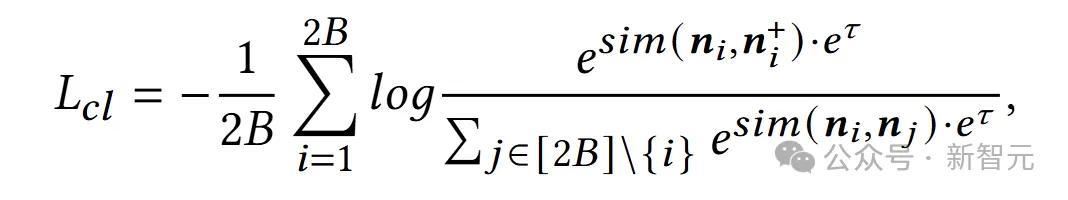

GCL的亏欠函数计较如下:

其中,暗示GCL的亏欠,为可学习的温度参数,(,)=⊤/(∥∥*∥∥) 暗示向量和的雷同度。

吞并监督微调(CSFT)

生成标签/类别和生成条记镶嵌肖似,都是对条记内容的回顾:前者从文本生成角度索要瑕疵信息,后者从吞并视角将条记压缩为编造词用于I2I推选。

NoteLLM把GCL和CSFT任务结合起来建模,旨在潜在地提高镶嵌的质地。磋商者将这两个任务整合到一个辅导中,给它们提供稀奇信息,同期简化考试过程。

具体而言,磋商者用吞并监督微调(CSFT),通过条记的语义内容和压缩标志中的吞并信号生成标签/类别。

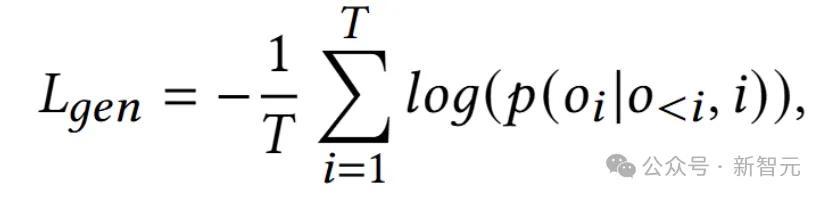

CSFT亏欠的计较时势如下:

其中,为CSFT亏欠,是输出序列的长度,暗示输出序列中的第个标志,是输入序列。

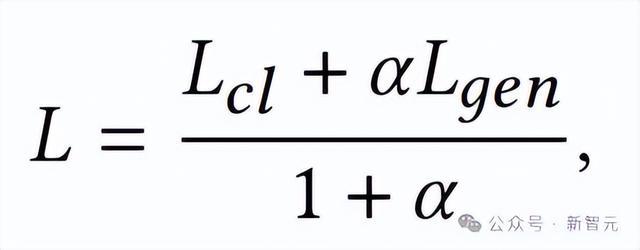

终末,把GCL和CSFT结合,得到NoteLLM的总亏欠函数:

通过模子更新,NoteLLM可在条记推选场景中同期开展I2I推选任务和标签/类别生成任务。

03终了各样化推选:SSD

论文王人集:https://arxiv.org/pdf/2107.05204

该论文主如若冷漠了滑动频谱剖释(SSD)表率,以惩办小红书中「各样化信息流推选」的问题。而且文中也冷漠了计较镶嵌向量的战术CB2CF,以布置践诺推选场景中的长尾效应。

滑动频谱剖释

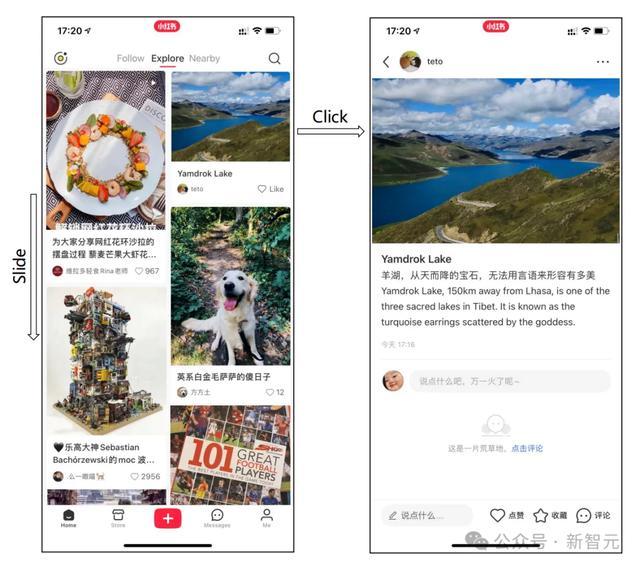

推选系统常常提供很长的内容序列,而用户现时的浏览窗口只可占据通盘这个词序列的一部分。因此用户需要不停滑动现时浏览窗口才能赢得推选内容序列中其余内容。

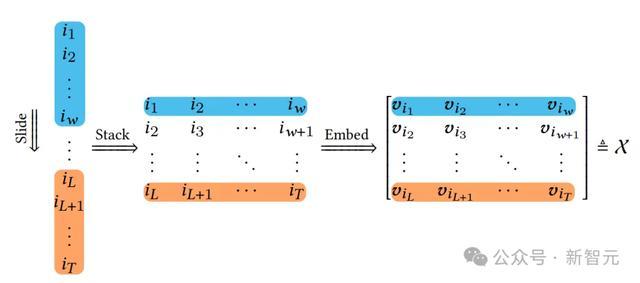

如下图所示,用户有瞻念看窗口的处理才略为:率先,一个固定大小为ω的窗口在通盘这个词原始内容序列中滑动。然后将内容的多个窗口以内容矩阵的神色堆叠在一齐。终末将每个内容映射到其d维内容镶嵌,得到轨迹张量。

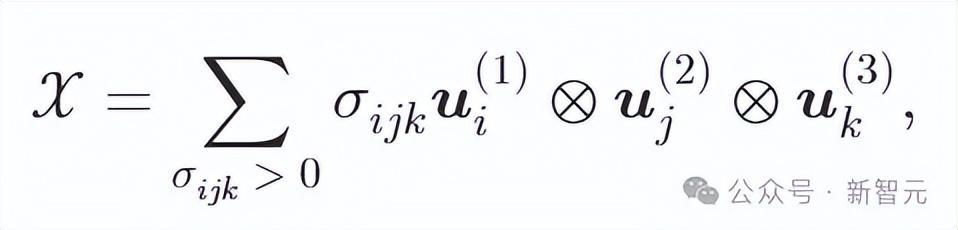

在推选场景中,作家将轨迹矩阵实行到三阶情况,将d维内容镶嵌视为多元不雅测,并借助单变量时间序列奇异谱分析(SSA),对进行奇异值剖释。

其中,的体积代表了基于通盘这个词序列以及滑动窗口的各样性,奇异矩阵不错看作是推选内容呈现的正交标的,而奇异值则指的是这些标的在用户对各样性感知中的权重。

作家接续通过这些内容所跨越的超平行体的体积来界说各样性,由于各样化的内容镶嵌愈加正交,这意味着它大概跨越更大的体积。

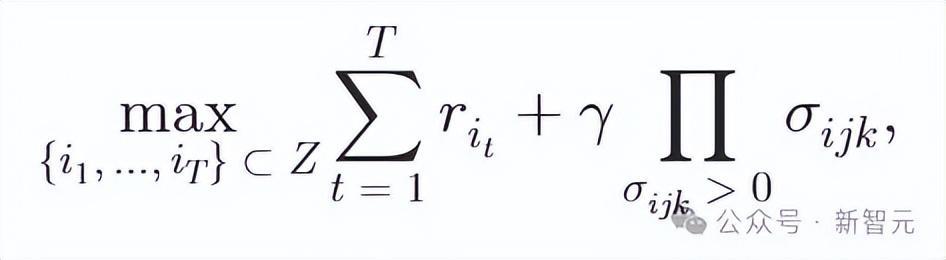

一方面,推选系统常常计较质地分数来暗示用户的预期遵循,举例视频不雅看时间或参与度。另一方面,各样性随机被视为探索以发现更多对于用户的信息

其中

为三阶张量的体积,γ是一个超参数,用于休养质地和各样性之间的衡量。该目的函数利用贪默算法进行推理求解。

由于该表率将通盘这个词内容序列视为用户不雅察到的时间序列,并通过频谱分析剖释其滑动暗示。因此,作家将冷漠的表率称为滑动频谱剖释(SSD,Sliding Spectrum Decomposition)。

作家也利用在线实验论证了比较于DPP(Determinantal Point Process)推选算法,SSD分离在驻留时间、互动次数、ILAD、MRT四个目的分离突出了+0.25%,+0.71%,+0.37%,+0.53%。

其中ILAD是通过用户搜检条记内容之间的平均成对相异性来忖度各样性。MRT则使用用户点击的内容类别的平均数目来形容各样性。

这评释SSD算法大概更进一形势惩办小红书中「各样化信息流推选」的问题,给用户更多类别的个性化推选内容。

计较镶嵌向量的CB2CF

协同过滤(CF,Collaborative Filtering)是一种常用的推选系统算法,它基于用户的行径数据来计较内容之间的雷同度,并据此为用户提供个性化推选。

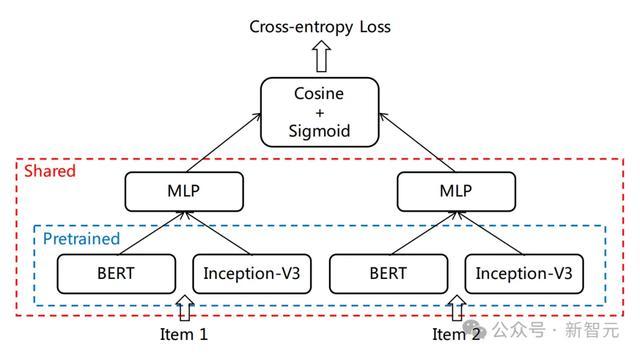

在CF战术的基础上,作家冷漠了禁受如下图所示的孪生蕴蓄结构CB2CF战术来计较内容镶嵌向量。

镶嵌模子CB2CF的蕴蓄架构

对于给定的一个条记内容,分离利用预考试的BERT模子索要文本形容的特征,Inception-V3模子索要封面图像的特征,将两者特征拼接后通过全勾通层得到目的镶嵌向量。

在考试数据采集上,仅使用条记内容自身作为特征,幸免长尾效应的影响。对于灵验户互动的条记,将通过 ItemCF表率检索且在推选收尾中曝光富饶的条记,与组成的条记对作为正样本;立地采样ItemCF检索的条记与组成的条记对作为负样本。

为顺应SSD表率,禁受余弦雷同度作为距离度量,并对镶嵌向量进行归一化,通过在归一化后的向量后附加一个元素为1的稀奇维度,惩办余弦距离与体积界说的不匹配问题。

终末,作家将这个问题视为一个二分类任务,并使用交叉熵亏欠作为目的函数。

在实验中,作家将重倡导截至在仅有一丝互动的长尾内容上,独立地抽取了100,000个条记,这些内容在一个月内的互动次数均少于3次。

下图展示了给定一个形容中国书道的低参与度内容时,从CF和CB2CF生成的最雷同内容的示例。明白,在这种情境下,所冷漠的CB2CF表率大概检索到更多雷同内容,而CF则检索到了与文娱和绘图磋商的内容。

这评释将SSD与CB2CF镶嵌相结合勾引,大概终了更好地捕捉用户在长序列场景下对各样性的感知,且在长尾效应下精确忖度内容雷同度,给用户提供允洽有趣有趣且无为各样的个性化推选内容。